Không ít người nổi tiếng bị ghép mặt bằng công nghệ đen tối này, hệ lụy nó đem lại thật không tưởng

Nhịp Sống Việt | 03/03/2021 09:28 AM

Bất cứ ai đều có thể bị ghép mặt vào các hình ảnh, clip nhạy cảm hoặc xuyên tạc sự thật.

Thời gian gần đây, không ít người nổi tiếng từ ca sĩ, diễn viên, cầu thủ bóng đá... bị tung clip nóng giả mạo. Chính xác hơn, họ bị ghép mặt vào những hình ảnh, clip gán mác 18+. Song bất ngờ hơn, chỉ cần thao tác một chút với công nghệ deepfake, những hình ảnh, video nóng giả mạo đã ra đời mà chân thật tới không ngờ.

Kẻ xấu chẳng chừa 1 ai, từ những ngôi sao hạng A cho đến người nổi tiếng đều có thể trở thành nạn nhân của công nghệ deepfake.

Gal Gadot

Việc ghép mặt một người nổi tiếng vào clip nóng là chuyện đã xảy ra rất nhiều. Nữ người mẫu, diễn viên Gal Gadot từng trở thành nạn nhân khi bị ghép mặt vào bộ phim khiêu dâm và đăng lên web đen.

Cô nàng "Wonder Woman" từng bị ghép mặt vào clip 18+.

Mark Zuckerberg

Người sáng lập Facebook cũng bị ghép mặt vào 1 video bằng deepfake. Trong đoạn clip này, Zuckerberg chia sẻ: "Hãy thử tưởng tượng đến điều này một giây thôi: Một người với quyền quản lý dữ liệu ăn trộm của hàng tỷ người, tất cả bí mật của họ, cuộc sống của họ, tương lai của họ."

Mặc dù gương mặt, các cử động miệng y như thật song đây vẫn chỉ là 1 sản phẩm của công nghệ mà thôi.

(Ảnh cắt từ clip)

Sao Hàn

Song Hye Kyo, Nancy (MOMOLAND)... là những sao Hàn cũng từng bị ghép mặt vào những bức ảnh, clip 18+ và lan truyền trên web đen.

Hình ảnh Song Hye Kyo bị lan truyền thực tế là ảnh ghép.

Gần đây nhất, khoảng tháng 1 vừa qua, không chỉ netizen xứ Hàn cả Blink quốc tế từng xôn xao bởi những clip nóng ghép hình mặt của các thành viên trong BLACKPINK. Jennie, Jisoo, Rosé, Lisa đều trở thành nạn nhân của trò cắt ghép này.

Công ty chủ quản của BLACKPINK - YG phải đứng ra giải quyết để bảo vệ quyền lợi và danh tiếng cho các cô gái. Bởi lẽ, việc này gây ảnh hưởng không ít tới danh tiếng của các thành viên BLACKPINK.

Các thành viên BLACKPINK cũng trở thành nạn nhân của deepfake.

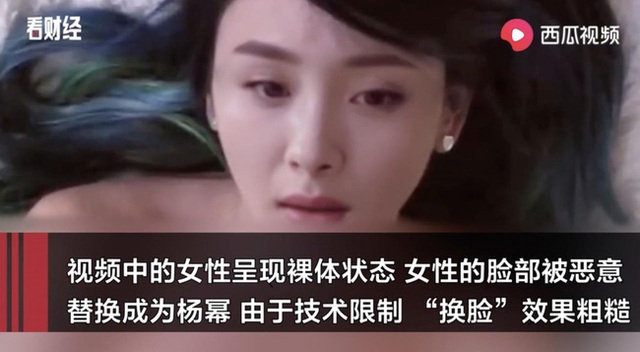

Sao Hoa ngữ

Dương Mịch là một trong những sao Hoa ngữ điển hình gây chấn động vì những hình ảnh 18+ giả mạo.

Theo SCMP, việc sử dụng trí thông minh nhân tạo (AI) để ghép mặt người nổi tiếng vào clip nóng đang ngày càng phổ biến tại Trung Quốc. Những kẻ tạo ra clip này sẽ đem bán với giá 4 nhân dân tệ (khoảng 13.000 đồng) cho mỗi video. Mua trọn gói 700 video có giá 158 nhân dân tệ (hơn 500.000 đồng).

DEEPFAKE LÀ GÌ?

Hiểu đơn giản, dữ liệu về đặc điểm khuôn mặt, hình thể sẽ được thu thập rồi được hợp nhất bởi trí tuệ nhân tạo (AI). Deepfake có thể tạo ra hình ảnh, video giả bằng cách gán khuôn mặt của người này sang người khác, với độ chân thực cao.

Và bất cứ ai cũng có thể trở thành nạn nhân của Deepfake: Người nổi tiếng, chính trị gia, quan chức cấp cao...

Theo thống kê của Deeptrace, công ty có trụ sở tại Amsterdam chuyên nghiên cứu về những nội dung được tạo ra bởi AI, 96% video Deepfake có nội dung đồi trụy. Hầu hết nạn nhân là ca sĩ, diễn viên nữ nổi tiếng bị ghép mặt vào các bộ phim khiêu dâm.

Ngoài Deepfake, DeepNude cũng là phần mềm lột đồ gây bức xúc. Nó được rao bán với giá 50 - 99 USD (1,1 - 2,3 triệu đồng). Nó hoạt động triệt để với hình ảnh có độ phân giải cao hoặc nhân vật vốn đã hở bạo.

NHỮNG HỆ LỤY KINH HOÀNG TỪ CÔNG NGHỆ GIẢ MẠO DANH TÍNH

Hơn 20 năm trước, người ta sử dụng Photoshop để ghép mặt Mr. Bean vào The Rock để gây cười. Còn kỹ xảo điện ảnh đã có từ những năm 1980, giúp các diễn viên bay lượn và biến hình trên màn ảnh rộng. Đó rõ ràng là cách ứng dụng công nghệ vào giải trí, nhưng mọi thứ có vẻ đang vượt ra khỏi tầm kiểm soát.

Giờ chỉ cần một máy tính đủ mạnh và phần mềm tạo video deepfake, bất cứ ai cũng có thể tạo ra video giả mạo danh tính của người khác. Nếu làm giả danh tính là chưa đủ, đến cả âm thanh, giọng nói cũng đã bị làm giả.

Trên internet ẩn danh, nạn nhân của Deepfake gần như bất lực trong việc chỉ mặt gọi tên thủ phạm. Họ cảm thấy bị xúc phạm, hoang mang cực độ trong khi pháp luật vẫn chưa chuyển mình đủ nhanh để bảo vệ họ. Ngoài ra, các chuyên gia dự đoán, Deepfake sẽ được kẻ xấu tận dụng để tạo tin giả, tiềm tàng nguy cơ xảy ra biến loạn xã hội trong tương lai.